Google Hacking Database는 특정 검색어(Dorks)를 사용하여 공개된 웹페이지에서 민감한 정보를 찾아내는 방법들을 모아둔 데이터베이스다. 이러한 검색어들은 구글 검색 엔진을 통해 취약한 서버나 파일, 민감한 정보를 쉽게 찾을 수 있도록 한다.

- Dork: 구글 검색에 사용할 수 있는 특수 검색어 또는 구문. 이를 통해 특정 유형의 정보를 검색할 수 있다.

- Category: 검색어가 어떤 유형의 취약점을 탐지하는지에 대한 분류. 예를 들어, 파일에 포함된 비밀번호, 취약한 서버, 민감한 정보 등이 포함된다.

- Date Added: 검색어가 데이터베이스에 추가된 날짜.

- Author: 해당 검색어를 제안한 사람.

'robots.txt' 파일은 웹사이트의 루트 디렉토리에 위치하는 텍스트 파일로, 웹 클로러(예: 검색 엔진 로봇)가 사이트의 어느 부분을 크롤링할 수 있는지 또는 크롤링해서는 안 되는지 지시한다. 보안 설정과 관련하여 'robots.txt' 파일이 올바르게 구성되지 않으면 민감한 정보나 중요한 파일이 검색 엔진에 의해 인덱싱 될 수 있다.

WebDAV를 사용하면 웹을 통해 파일을 생성, 수정, 삭제할 수 있으며, 다른 사용자와 협업하거나 파일의 버전을 관리할 수 있다.

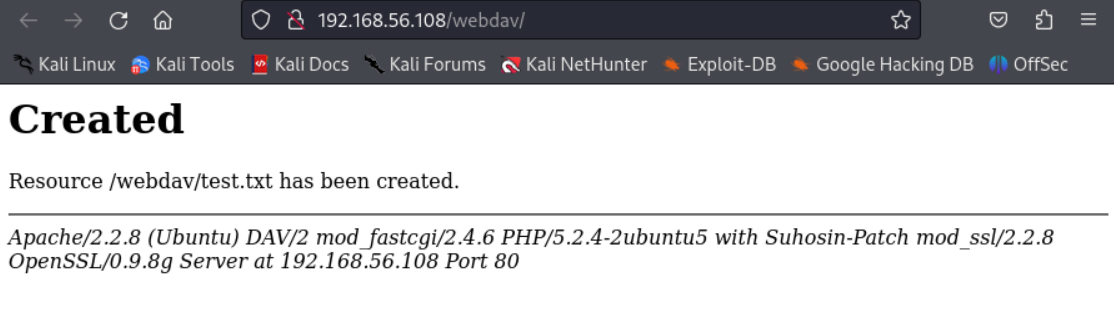

아래와 같이 파일이 생성된 걸 볼 수 있다.

파일 내용도 정상적으로 들어갔다.

이렇게 파일 권한이 너무 허용적이면 무단 데이터 수정이나 노출이 발생할 수 있다. 파일 시스템 권한과 WebDAV 설정을 사용하여 권한이 있는 사용자만 접근할 수 있도록 설정해야 한다.

'Study records > Web hacking' 카테고리의 다른 글

| [Beebox] 기능 수준의 접근 통제 누락(디렉터리 리스팅/파일 삽입) (0) | 2024.07.18 |

|---|---|

| [Beebox] 인코딩 복호화/HTML5 웹 저장소/중요 정보 텍스트 파일 저장 (0) | 2024.07.18 |

| [Beebox] 취약한 직접 객체 참조(Insecure DOR) (0) | 2024.07.17 |

| [Beebox] 크로스 사이트 스크립트(XSS) 취약점 (0) | 2024.07.17 |

| [Beebox] 세션 관리 미흡에 의한 취약점 (0) | 2024.07.16 |